21 0 0 0 OA DARPAロボティクスチャレンジ決勝戦でのロボットシステム開発と教訓

- 著者

- 梶田 秀司 森澤 光晴 中岡 慎一郎 シスネロス ラファエル 阪口 健 金子 健二 金広 文男

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.34, no.6, pp.360-365, 2016 (Released:2016-08-15)

- 参考文献数

- 12

- 被引用文献数

- 1 2

- 著者

- 中岡 慎一郎 服部 静子 金広 文男 梶田 秀司 比留川 博久

- 出版者

- 一般社団法人 日本機械学会

- 雑誌

- ロボティクス・メカトロニクス講演会講演概要集 2007 (ISSN:24243124)

- 巻号頁・発行日

- pp._1A1-A08_1-_1A1-A08_4, 2007-05-11 (Released:2017-06-19)

This paper describes a LCP-based method for calculating contact forces in dynamics simulation of humanoid robots. The method is based on the algorithm proposed by Kokkevis, and we propose additional procedures that make the algorithm more practical in the reality and numerical stability. The simulation system is verified by experiments using humanoid robot HRP-2, and the result shows the efficiency and validity of the method.

- 著者

- 中野 倫靖 後藤 真孝 梶田 秀司 松坂 要佐 中岡 慎一郎 横井 一仁

- 雑誌

- 情報処理学会論文誌 (ISSN:18827764)

- 巻号頁・発行日

- vol.55, no.3, pp.1222-1235, 2014-03-15

本論文では,ユーザ歌唱における顔表情を真似てヒューマノイドロボットの顔動作を生成するVocaWatcherについて述べる.ここで,我々が以前開発したVocaListenerを用い,ユーザ歌唱の歌い方(音高と音量)を真似て歌声合成も行う.従来,歌唱ロボットに関する研究はあったが,手作業による動作制御が主で,その自然さに限界があった.それに対して本研究では,単一のビデオカメラで収録した人間の歌唱動画を画像解析し,口,目,首の動作を真似て制御することで,自然な歌唱動作を生成した.ここで口の制御には,VocaListenerから得られる歌詞のタイミング情報を用いて,歌声に同期した動作を生成できる.さらに,ロボットによるより自然な歌唱を実現するために,我々が以前開発したブレス音の検出技術とVocaListenerを組み合わせ,ブレス音を真似て合成できるように拡張した.In this paper, we describe VocaWatcher that is a facial-motion generator for a singing robot by imitating user's singing. It can synthesize singing voices by using our previous VocaListener to imitate pitch (F0) and dynamics (power) of user's singing. Although singing humanoid robots have been developed with synthesized singing voices, such robots do not appear to be natural because of limitations of manual control. To generate natural singing expressions, VocaWatcher imitates a human singer by analyzing a video clip of human singing recorded by a single video camera. VocaWatcher can control mouth, eye, and neck motions by imitating the corresponding human movements. To control the mouth motion, VocaWatcher uses lyrics with precise timing information provided by VocaListener. Moreover, we extended VocaListener by combining our previous method of breath sound detection to imitate breathing sounds that make the robot singing more realistic.

- 著者

- 橘 誠 中岡 慎一郎 剣持 秀紀

- 出版者

- 情報処理学会

- 雑誌

- 研究報告音楽情報科学(MUS) (ISSN:09196072)

- 巻号頁・発行日

- vol.2010, no.14, pp.1-6, 2010-02-08

本稿では,2009年10月に開催されたCEATEC JAPAN 2009にて,ヤマハブースに出展した歌声合成システムVOCALOIDと産業技術総合研究所が開発したサイバネティックヒューマンHRP-4C"未夢"のコラボレーションによる歌うロボットの演出について,その概要とデモシステムの技術を紹介する.This paper describes the technique applied to a robot to perform singing-voice as exhibited at CEATEC JAPAN 2009. To achieve a realistically robot-singing performance, facial motions such as lip-sync and facial gestures are required. This work is a result of a collaboration between the technology "VOCALOID" (developed by YAMAHA) and the cybernetic Human HRP-4C named "Miim" (developed by AIST). We report the technical overview of the system developed for the mentioned exhibition.

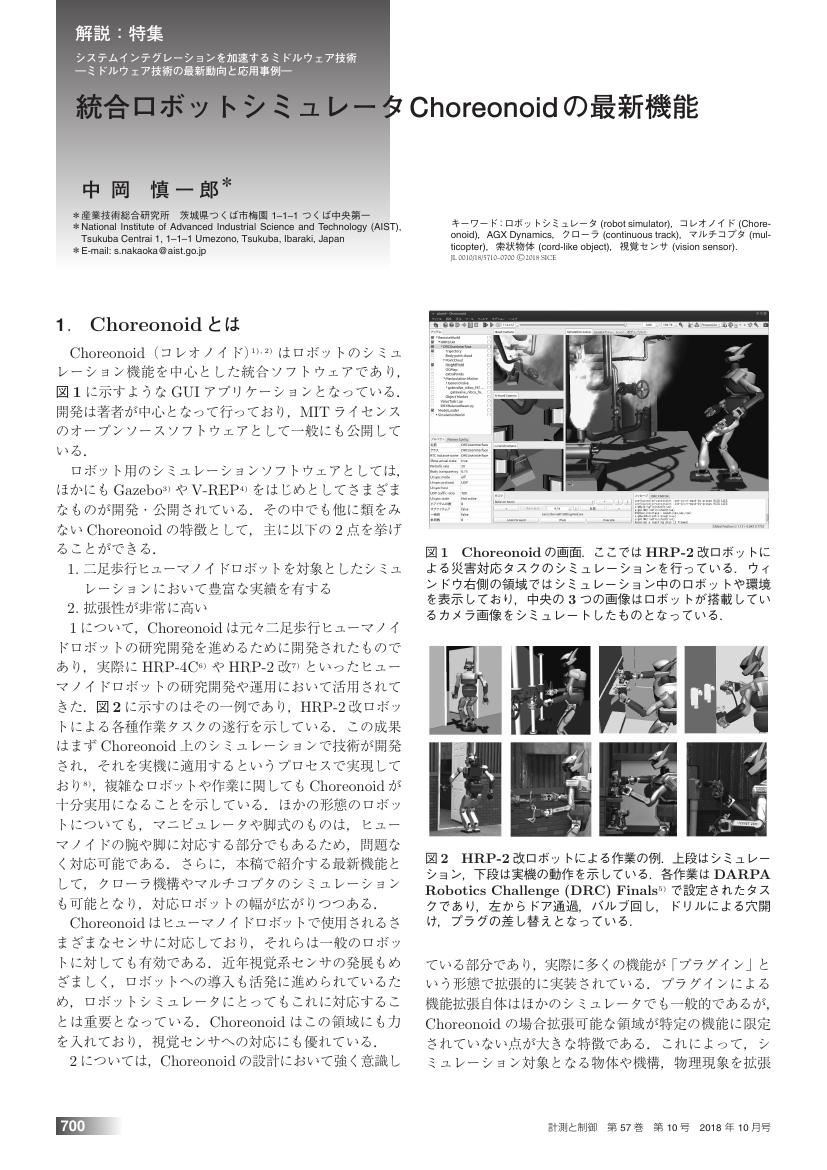

1 0 0 0 OA 統合ロボットシミュレータChoreonoidの最新機能

- 著者

- 中岡 慎一郎

- 出版者

- 公益社団法人 計測自動制御学会

- 雑誌

- 計測と制御 (ISSN:04534662)

- 巻号頁・発行日

- vol.57, no.10, pp.700-705, 2018-10-10 (Released:2018-10-13)

- 参考文献数

- 18

1 0 0 0 OA サイバネティックヒューマンHRP-4Cの開発 —プロジェクト概要からシステム設計まで—

- 著者

- 金子 健二 金広 文男 森澤 光晴 三浦 郁奈子 中岡 慎一郎 原田 研介 梶田 秀司

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.28, no.7, pp.853-864, 2010 (Released:2012-01-25)

- 参考文献数

- 42

- 被引用文献数

- 7 6

The development of cybernetic human HRP-4C is presented in this paper. The word “Cybernetic Human” is a coinage for us to explain a humanoid robot with a realistic head and a realistic figure of a human being. HRP-4C stands for Humanoid Robotics Platform-4 (Cybernetic human). Standing 158[cm] tall and weighing 43[kg] (including batteries), with the joints and dimensions set to average values for young Japanese females, HRP-4C looks very human-like. This paper introduces the project overview, the design process, mechanical features, and electrical features with specifications of HRP-4C.

1 0 0 0 OA 拡張可能なロボット用統合GUI環境 Choreonoid

- 著者

- 中岡 慎一郎

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.31, no.3, pp.226-231, 2013 (Released:2013-05-15)

- 参考文献数

- 14

- 被引用文献数

- 2 3

1 0 0 0 伝統舞踊の獲得における動作理解

- 著者

- 工藤 俊亮 中岡 慎一郎 白鳥 貴亮

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 = Journal of Robotics Society of Japan (ISSN:02891824)

- 巻号頁・発行日

- vol.25, no.5, pp.665-670, 2007-07-15

- 参考文献数

- 10

1 0 0 0 OA 遠隔操作による災害対応ヒューマノイドロボットHRP-2改

- 著者

- 森澤 光晴 中岡 慎一郎 金子 健二 シスネロス ラファエル 梶田 秀司 阪口 健 金広 文男

- 出版者

- 一般社団法人 電子情報通信学会

- 雑誌

- 電子情報通信学会 通信ソサイエティマガジン (ISSN:21860661)

- 巻号頁・発行日

- vol.10, no.3, pp.173-178, 2016 (Released:2016-12-01)

- 参考文献数

- 7

1 0 0 0 OA 「海鷹丸」による南大洋の大気中硫化ジメチル濃度観測

2009年1月から2月の南半球の夏期間に,東京海洋大学の研究練習船「海鷹丸」にプロトン移動反応質量分析計を搭載して,南大洋の大気中の硫化ジメチル濃度の連続観測を実施した.海鷹丸は昭和基地沖とケープダンレー沖の氷縁域を含む南大洋を航行し,研究観測を実施した.この海域での大気中の硫化ジメチル濃度の連続観測は初めてである.海水中の硫化ジメチル濃度の観測も行われ,そのデータとの対比が可能となった.大気中の連続観測から,昭和基地沖およびケープダンレー沖の氷縁域では,2ppbを越える高い濃度の硫化ジメチルが観測された.

1 0 0 0 複数舞踊動作からの個性の抽出および適用

- 著者

- 中澤 篤志 中岡 慎一郎 池内 克史

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 情報処理学会研究報告コンピュータビジョンとイメージメディア(CVIM) (ISSN:09196072)

- 巻号頁・発行日

- vol.2003, no.36, pp.101-107, 2003-03-27

- 被引用文献数

- 7

本稿では,伝統舞踊に代表される人の動きをデジタル保存する研究の一環として,舞踊における「基本動作」と「個人の個性(動作スタイル)」を自動的に抽出することを目標としている.従来の研究例では,モーションキャプチャ等によって得られた動作データを何らかの基準でセグメンテーションし,そのデータをそのまま用いてアニメーションを生成したり,動作解析に用いるものが多かった.これに対し我々は,舞踊における動作は個々人に共通する基本動作と,個人の個性を示す動作スタイルに分離できると考え,アルゴリズムを設計した.たここで得られた解析結果を用いて,ユーザが設定したパラメータによって複数動作を合成し,新たな動作を合成することが可能になった.実験では,同一舞踊を男女で演じたデータを用い,本手法を適用することによって,その有効性を確認した.This paper presents the method to analyze human motion for the purpose of digital archive of intangible cultural heritages, such as folk dances. In the recent studies, the whole motion sequence is segmented and directly used for computer animation or motionanalysis. we proposes the ides that the human dance motion consists of "Basic Motion" and "Motion Styles". The Basic Motion is common motion for any dancers, and Mtion Styles represents the uniqueness of the individual dancers. In the experiment, we confirmed proposed method works effectively through different motion data of male and femail dancers.