5 0 0 0 OA 擬似生成した複数方言言語モデル混合による混合方言音声認識

- 著者

- 平山 直樹 吉野 幸一郎 糸山 克寿 森 信介 奥乃 博

- 雑誌

- 情報処理学会論文誌 (ISSN:18827764)

- 巻号頁・発行日

- vol.55, no.7, pp.1681-1694, 2014-07-15

本論文では,様々な方言の混合に対応する音声認識システムを構築する.まず,単一方言音声認識の言語モデルを,大規模共通語言語コーパスから擬似生成した方言言語コーパスで学習する.擬似生成には,共通語-方言対訳コーパスからWFST(重み付き有限状態トランスデューサ)によって学習されたルールを用いる.次に,構築された各方言言語モデルを混合し,発話ごとに最適な混合比を推定しながら認識を行う.これは,実際に話される方言が純粋な単一方言ではなく,人の移動やテレビ,ラジオなどの放送の影響を受けた様々な方言の混合であると考えられるからである.この推定には,音声認識用言語モデルにおける対数尤度の値を用いる.実験により,方言音声認識用言語モデルを用いて方言音声の認識精度が向上することを確認した.また,対数尤度と音声認識精度に強い相関があること,対数尤度を最大化する混合比を発話ごとに選択することで,固定混合比の場合と比較して音声認識精度が向上することを確認した.

4 0 0 0 並列Lisp言語QLispによるOPS5の並列処理の記述

- 著者

- 奥乃 博 グプタアヌープ

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 情報処理学会論文誌 (ISSN:18827764)

- 巻号頁・発行日

- vol.31, no.6, pp.822-831, 1990-06-15

- 被引用文献数

- 1

プロダクション・システム(あるいはルールベース・システム)は広くエキスパート・システム構築用ツールとして使用されている.広範な応用あるいは実時間応用にプロダクショシ・システム高速化が不可欠であり 並列処理による高速化が研究されている.従来の研究では低レベル言語を使用しているため 他のシステムとの融合が難しかった.また OPS5 はエキスパート・システム構築用ツールであり その並列度はユーザ・プログラムに大きく依存している.本論文では OPS5 を共有メモリ型マルチプロセッサ上で高級言語を用いて並列処理する上での様々な問題点について議論する.本論文の主要な主張点は(1)並列 Lisp 言語 QLisp による並列処理の記述 (2)実行時に並列度を決定する制御方式 (3)プロタクション・システムの競合解消と行動段階での新しい並列処理アルゴリズムの提案 である.とくに実行時並列度制御方式は 個々のタスクの処理時間にばらつきのある記号処理では 資源の有効利用には不可欠である.また 行動段階での並列処理は競合解消で選択される可能性のあるルールを先行実行するという概念に基づいている.高級言語を用いることにより多様な並列性は容易に記述することができた.

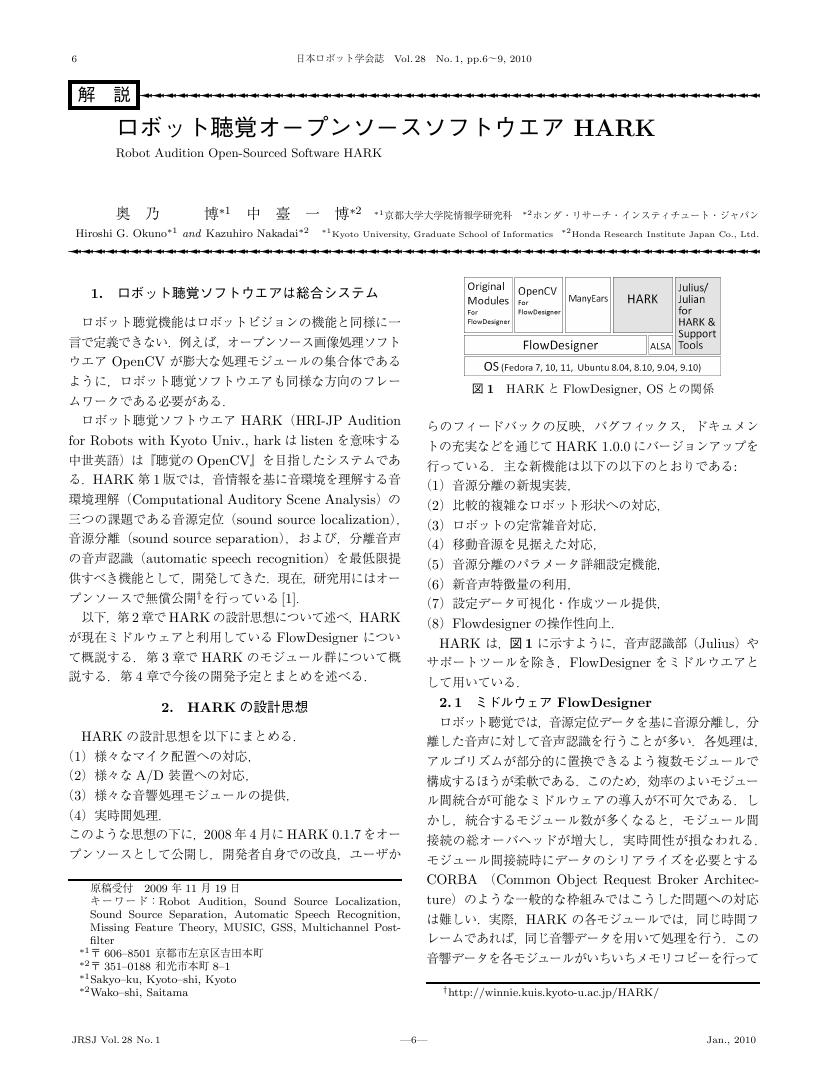

2 0 0 0 OA ロボット聴覚オープンソースソフトウエアHARK

- 著者

- 奥乃 博 中臺 一博

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.28, no.1, pp.6-9, 2010 (Released:2012-01-25)

- 参考文献数

- 4

- 被引用文献数

- 4 2

2 0 0 0 二分決定グラフによる探索型組合せ問題の解法での組合せ的爆発抑制法

- 著者

- 奥乃 博

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 情報処理学会論文誌 (ISSN:18827764)

- 巻号頁・発行日

- vol.35, no.5, pp.739-753, 1994-05-15

- 被引用文献数

- 8

二分決定グラフ(BDD)で組合せ問題の全解を同時に求めることを検討する。この問題での課題は、計算途中で生じる組合せ的爆発を避け、同じ計算機資源のもとでできるだけ大きな問題が解ける手法を開発することである。従来から知られていたBDDの問題点は、最終ノード数を最小にする最適変数順序を求めることである。本稿では、組合せ問題にBDDを適用する場合には最大ノード数が重要であること、および、それが変数順序だけでなく制約組合せ順序の影響を受けることを指摘する。次に、最大ノード数を最小にする制約順序と変数順序の最適解を見つけるアルゴリズムCCVOを提案する。さらに、最大ノード数が大き過ぎて計算ができない場合には、オンライン版分割統治法を使用する解法を提案し、その分割ヒューリスティックを提案する。これらの手法により、12?Queensを128Mbyte主記憶で解くことができ、また、分割統治法により13?Queensと4次の魔法陣を解くことができた。二分決定グラフでは途中結果がすべて保存されているので、オンライン型分割統治法による解法は、オフライン型分割統治法よりも高速である・

2 0 0 0 OA RNNを備えた2体のロボット間における身体性に基づいた動的コミュニケーションの創発

- 著者

- 日下 航 尾形 哲也 小嶋 秀樹 高橋 徹 奥乃 博

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.28, no.4, pp.532-543, 2010 (Released:2012-01-25)

- 参考文献数

- 29

- 被引用文献数

- 1

We propose a model of evolutionary communication with voice signs and motion signs between two robots. In our model, a robot recognizes other's action through reflecting its self body dynamics by a Multiple Timescale Recurrent Neural Network (MTRNN). Then the robot interprets the action as a sign by its own hierarchical Neural Network (NN). Each of them modifies their interpretation of signs by re-training the NN to adapt the other's interpretation throughout interaction between them. As a result of the experiment, we found that the communication kept evolving through repeating miscommunication and re-adaptation alternately, and induced the emergence of diverse new signs that depend on the robots' body dynamics through the generalization capability of MTRNN.

2 0 0 0 多重奏楽曲の楽器音量バランス変化による音楽ジャンルシフト

- 著者

- 糸山 克寿 後藤 真孝 駒谷 和範 尾形 哲也 奥乃 博

- 出版者

- 情報処理学会

- 雑誌

- 研究報告音楽情報科学(MUS) (ISSN:09196072)

- 巻号頁・発行日

- vol.2009, no.3, pp.1-6, 2009-07-22

本報告では,楽曲の楽器パート音量操作によってユーザがクエリをカスタマイズすることが可能な類似楽曲検索手法を提案する.楽曲の雰囲気やジャンルは楽曲を構成する楽器およびその音量バランスと強く関係する,という仮説に基づく.楽曲の音響信号を楽譜に基づいて楽器パートへと分離し,その分離信号の音量を操作することで楽曲の音響的特徴を変化させる.楽曲の音響特徴はガウス混合分布で表現され,楽曲間の類似性を分布間の Earth Movers Distance で定義する.実験により,歌声,ギター,ドラムスパートの音量を操作した際にジャンルシフトが起こることを示す.This report presents a novel Query-by-Example (QBE) approach in Music Information Retrieval, which allows a user to customize query examples by directly modifying the volume of different instrument parts. The underlying hypothesis is that the musical genre shifts (changes) in relation to the volume balance of different instruments. Our QBE system first separates the musical audio signal into all instrument parts with the help of its musical score, and then lets a user remix those parts to change acoustic features that represent musical mood of the piece. The distribution of those features is modeled by the Gaussian Mixture Model for each musical piece, and the Earth Movers Distance between mixtures of different pieces is used as the degree of their mood similarity. Experimental results showed that the shift was actually caused by the volume change of vocal, guitar, and drums.

2 0 0 0 OA 音環境理解から観たロボット聴覚(<小特集>ロボットにおける音響技術)

- 著者

- 奥乃 博

- 出版者

- 一般社団法人 日本音響学会

- 雑誌

- 日本音響学会誌 (ISSN:03694232)

- 巻号頁・発行日

- vol.63, no.1, pp.29-34, 2006-12-25 (Released:2017-06-02)

- 参考文献数

- 21

2 0 0 0 音響特徴・ベース音・和音遷移を用いた自動和音認識

- 著者

- 糸山 克寿 尾形 哲也 奥乃 博

- 雑誌

- 研究報告音楽情報科学(MUS)

- 巻号頁・発行日

- vol.2012, no.29, pp.1-7, 2012-01-27

本稿では,多重奏音楽音響信号に対する自動和音和音手法について述べる.和音の認識においては,音楽的要素の関連性を考慮することが重要である.我々は,和音を表現する音響特徴であるクロマベクトルに加えて和音と関わりの深い音楽的要素であるベース音を用いた自動和音認識手法を構築した.和音遷移のパターンを事前に階層 Pitman-Yor 言語モデルで学習し,Viterbi アルゴリズムに基づく最大事後確率推定で和音系列を推定する.Beatles の 150 楽曲を用いた評価実験で,本手法は 73.7% の認識率を達成した.This paper describes a method that identifies musical chords in polyphonic musical signals. As musical chords mainly represent the harmony of music and are related to other musical elements such as melody and rhythm, we should be able to recognize chords more effectively if this interrelationship is taken into consideration. We use bass pitches as clues for improving chord recognition. The proposed chord recognition system is constructed based on Viterbi-algorithm-based maximum a posteriori estimation that uses a posterior probability based on chord features, chord transition patterns, and bass pitch distributions. Experimental results with 150 Beatles songs that has keys and no modulation showed that the recognition rate was 73.7% on average.

2 0 0 0 ギター演奏者の習熟度に合わせた音響信号からのタブ譜自動生成

- 著者

- 矢澤一樹 糸山克寿 奥乃博

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 研究報告音楽情報科学(MUS)

- 巻号頁・発行日

- vol.2013, no.17, pp.1-6, 2013-08-24

本稿では,ギター演奏者の演奏支援をするために実際のギター演奏音から演奏者の習熟度に応じたタブ譜を自動生成する手法について述べる.具体的には,初級者向けには音符の欠落などを許容してでも演奏が容易なタブ譜を,上級者向けには音高を正確に再現するタブ譜を,それぞれ生成する.推定される運指の難易度は,音響再現度と運指容易度の相対的な重みをユーザー側で調整することによって変更可能である.本手法によって得られたタブ譜について音響再現度と運指容易度の両面から評価を行った結果,パラメータを変更することによって音高推定の適合率を保ったまま運指を簡略化できることが確認された.

2 0 0 0 OA ぺた語義:京大における Lisp を使ったプログラミング教育

- 著者

- 石原 一志 坪田 康 奥乃 博

- 出版者

- 一般社団法人電子情報通信学会

- 雑誌

- 電子情報通信学会技術研究報告. SP, 音声 (ISSN:09135685)

- 巻号頁・発行日

- vol.103, no.154, pp.19-24, 2003-06-19

- 被引用文献数

- 4

環境音を擬音語に変換するうえでの問題として,擬音語表現が聴者により異なるという聴者依存性の問題が挙げられる.本研究は擬音語への変換処理を聴者に依存する処理と依存しない処理に分けることでこの問題を回避し,3段階の処理により環境音を擬音語に変換する手法を提案する.(1)時間軸上のパワー包絡から環境音を音節単位で切り分け,(2)音長・減衰速度から音節構造を同定し,(3)音素グループを利用した音素認識により音節構造を擬音語に変換する.認識実験によりこれらの手法の妥当性を確認した.セグメンテーションでは83.7 %/ 99.1‰長音の認識では84.6 %/ 100.0 %の適合率/再現率を得た.

2 0 0 0 Lispの最近の動向:Lispのプログラミング環境

- 著者

- 奥乃 博 丸山 宏

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 情報処理 (ISSN:04478053)

- 巻号頁・発行日

- vol.26, no.7, pp.p741-749, 1985-07-15

- 被引用文献数

- 1

1 0 0 0 OA 神経力学モデルによる予測可能性を用いた身体識別

認知ロボティクスにおいて身体図式の獲得は重要なテーマの一つである。従来研究では運動指令値と視覚を相関学習させるため,視覚中の身体位置が既知であることが前提であった。対して本手法は「予測(操作) できる部分が身体である」という考えに基づき、運動指令値と視覚の関係を予測学習することによって画像中の他者と自己の身体識別を可能とした。具体的には神経力学モデルであるMTRNN に運動指令値及び自己と他者の身体を含む視覚情報を入力し予測学習させ,予測可能部分を自己身体とした。実験の結果,MTRNN は運動指令値のみから自己身体を他者身体に比べ平均10 倍の精度で予測できることが確認された。

1 0 0 0 音色の音高依存性を考慮した楽器音の音高操作手法

- 著者

- 安部 武宏 糸山克寿 吉井 和佳 駒谷 和範 尾形 哲也 奥乃 博

- 雑誌

- 情報処理学会論文誌 (ISSN:18827764)

- 巻号頁・発行日

- vol.50, no.3, pp.1054-1066, 2009-03-15

- 被引用文献数

- 1

本稿では,ある音高を持つ楽器音をもとにして,音色の歪みを抑えながら任意の音高を持つ楽器音を合成する手法について述べる.我々は音色の聴感上の差に関する音響心理学的知見に基づき,楽器音のスペクトログラム上で観察される音色特徴量として,(i) 倍音ピーク間の相対強度,(ii) 非調波成分の分布,(iii) 時間方向の振幅エンベロープの3つを定義する.まず,もとになる楽器音の音色特徴量を分析するため,糸山らの調波·非調波統合モデルを用いて楽器音を調波構造と非調波構造に分離する.音高操作時には,特徴量(i),(ii) の音高依存性を考慮しなければならない.そのため,音高に対する特徴量を3次関数で近似し,所望の音高における特徴量の値を予測する.32種類の楽器に対して音高操作を試みたところ,音高依存性を考慮しない場合と比べて合成音と実際の楽器音との距離が,スペクトル距離尺度では64.70%,MFCC距離尺度では32.31%減少し,手法の有効性が確かめられた.This paper presents a synthesis method that can generate musical instrument sounds with arbitrary pitches from a given musical instrument sound while constraining distorting timbral characteristics. Based on the psychoacoustical knowledge on auditory effects of timbre, we define timbral features on the spectrogram of a musical instrument sound as (i) relative amplitudes of harmonic components, (ii) distribution of inharmonic components, and (iii) temporal envelopes of harmonic components. First, to analyze timbral features of a seed, it is separated into harmonic and inharmonic components by using Itoyama's integrated model. In pitch manipulation, it is necessary to take into account the relation of pitch and features (i) and (ii). Therefore, we predict the values of each feature by using a cubic polynomial that approximates the feature distribution over pitches. Experimental results showed the effectiveness of our method; the spectral and MFCC distances between synthesized sounds and real sounds of 32 instruments were reduced by 64.70% and 32.31%, respectively.

1 0 0 0 OA 音声対話システムにおける音韻的類似表現の混同を防ぐための確認の自動生成

- 著者

- 浜辺 良二 駒谷 和範 尾形 哲也 奥乃 博

- 雑誌

- 情報処理学会研究報告自然言語処理(NL)

- 巻号頁・発行日

- vol.2005, no.50(2005-NL-167), pp.89-94, 2005-05-27

音声対話システムにおいて,聞き取りやすさを考慮したシステム応答側の発話内容や言語表現についてはほとんど研究されていない.本研究では,システムの語彙内の音韻的に類似した単語に対して,それらを聞き分けやすくする新たな単語を付加した確認を自動的に生成する.まず,複数の知識源を利用して,付加する単語の候補を複数取得する.さらに確認の適切性を測る尺度を定義することにより,候補から最適な確認表現を自動的に選択する.京都市バス運行情報システムおよびホテル検索システムの語彙に対して,本手法により確認を生成し評価を行った.被験者5名に対する聴取実験により,生成した確認によって音韻的に類似した単語の聞き分けが改善されることを確認し,本手法の有効性を示した.

1 0 0 0 OA 環境音を対象とした擬音語自動認識 擬音語表現における音素決定曖昧性の解消

- 著者

- 石原 一志 駒谷 和範 尾形 哲也 奥乃 博

- 出版者

- 一般社団法人 人工知能学会

- 雑誌

- 人工知能学会論文誌 (ISSN:13460714)

- 巻号頁・発行日

- vol.20, no.3, pp.229-236, 2005 (Released:2005-03-23)

- 参考文献数

- 13

- 被引用文献数

- 2 2

Environmental sounds are very helpful in understanding environmental situations and in telling the approach of danger, and sound-imitation words (sound-related onomatopoeia) are important expressions to inform such sounds in human communication, especially in Japanese language. In this paper, we design a method to recognize sound-imitation words (SIWs) for environmental sounds. Critical issues in recognizing SIW are how to divide an environmental sound into recognition units and how to resolve representation ambiguity of the sounds. To solve these problems, we designed three-stage procedure that transforms environmental sounds into sound-imitation words, and phoneme group expressions that can represent ambiguous sounds. The three-stage procedure is as follows: (1) a whole waveform is divided into some chunks, (2) the chunks are transformed into sound-imitation syllables by phoneme recognition, (3) a sound-imitation word is constructed from sound-imitation syllables according to the requirements of the Japanese language. Ambiguity problem is that an environmental sound is often recognized differently by different listeners even under the same situation. Phoneme group expressions are new phonemes for environmental sounds, and they can express multiple sound-imitation words by one word. We designed two sets of phoneme groups: ``a set of basic phoneme group'' and ``a set of articulation-based phoneme group'' to absorb the ambiguity. Based on subjective experiments, the set of basic phoneme groups proved more appropriate to represent environmental sounds than the articulation-based one or a set of normal Japaneses phonemes.

1 0 0 0 OA 擬音語自動認識に基づいた環境音検索システム

- 著者

- 石原 一志 駒谷 和範 尾形 哲也 奥乃 博

- 雑誌

- 第67回全国大会講演論文集

- 巻号頁・発行日

- vol.2005, no.1, pp.371-372, 2005-03-02

- 著者

- 中臺 一博 日台 健一 溝口 博 奥乃 博 北野 宏明

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.21, no.5, pp.517-525, 2003-07-15

- 参考文献数

- 11

- 被引用文献数

- 6 3

This paper describes a real-time human tracking system by audio-visual integrtation for the humanoid <I>SIG</I>. An essential idea for real-time and robust tracking is hierarchical integration of multi-modal information. The system creates three kinds of streams - auditory, visual and associated streams. An auditory stream with sound source direction is formed as temporal series of events from audition module which localizes multiple sound sources and cancels motor noise from a pair of microphones. A visual stream with a face ID and its 3D-position is formed as temporal series of events from vision module by combining face detection, face identification and face localization by stereo vision. Auditory and visual streams are associated into an associated stream, a higher level representation according to their proximity. Because the associated stream disambiguates parcially missing information in auditory or visual streams, “focus-of-attention” control of <I>SIG</I> works well enough to robust human tracking. These processes are executed in real-time with the delay of 200 msec using off-the-shelf PCs distributed via TCP/IP. As a result, robust human tracking is attained even when the person is visually occluded and simultaneous speeches occur.

1 0 0 0 OA マイクロフォンアレイとロボット聴覚を用いた野鳥の歌行動観測と生態理解への試み

本研究は、マイクロフォンアレイとロボット聴覚を用いて鳥類の歌コミュニケーションを自動観測し、歌の種類と位置情報から鳥個体間で行われる歌を介した相互作用を明らかにすること、そしてその知見を野鳥の生態理解へ応用することを目的とした。当該システムの活用により、森林と草原という異なった自然環境下で、これまでの観測手法では容易に得られなかった位置情報付きの音声データの収集が実現した。さらに鳥類の音声データの収集やその解析効率、再現検証性が向上した。またこれらの音声データの解析により、観測対象種の個体間において、各個体が同時に鳴くことを避ける時間的重複回避行動が明らかになった。

1 0 0 0 不正投票問題を防ぐ単一認証局による電子投票システムの提案と実装

- 著者

- 鬼頭 利之 梅澤 健太郎 奥乃 博

- 雑誌

- 第62回全国大会講演論文集

- 巻号頁・発行日

- vol.2001, no.1, pp.407-408, 2001-03-13