2 0 0 0 OA 重み付け尤度関数と定在波を用いた可聴音による二次元環境認識

- 著者

- 岸波 華彦 糸山 克寿 西田 健次 中臺 一博

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.39, no.3, pp.271-274, 2021 (Released:2021-04-28)

- 参考文献数

- 11

In recent years, many kinds of sensors have been studied to recognize the environment, and they are used for AR and VR applications and for SLAM. Although ultrasonic signals with high directivity and high resolution are often used, there are problems such as ultrasonic exposure and grating noise at the rising edge. In this paper, we propose a new active sensing method based on audible sounds that is robust to environmental noise by combining weighting likelihood functions and standing waves. Compared to ultrasonic signals, audible sound tends to spread out, which leads to misalignment of distance estimates and loss of map consistency over time. Therefore, we derive the effective azimuth angle based on the directional characteristics of the speaker and calculate the likelihood of the presence or absence of obstacles using the observation model. In addition, we introduce occupancy grid mapping to produce a map that best explains the estimated distances. We performed real-world two-dimensional environment recognition experiments using the proposed method to detect and map surrounding obstacles, and showed the effectiveness of the method.

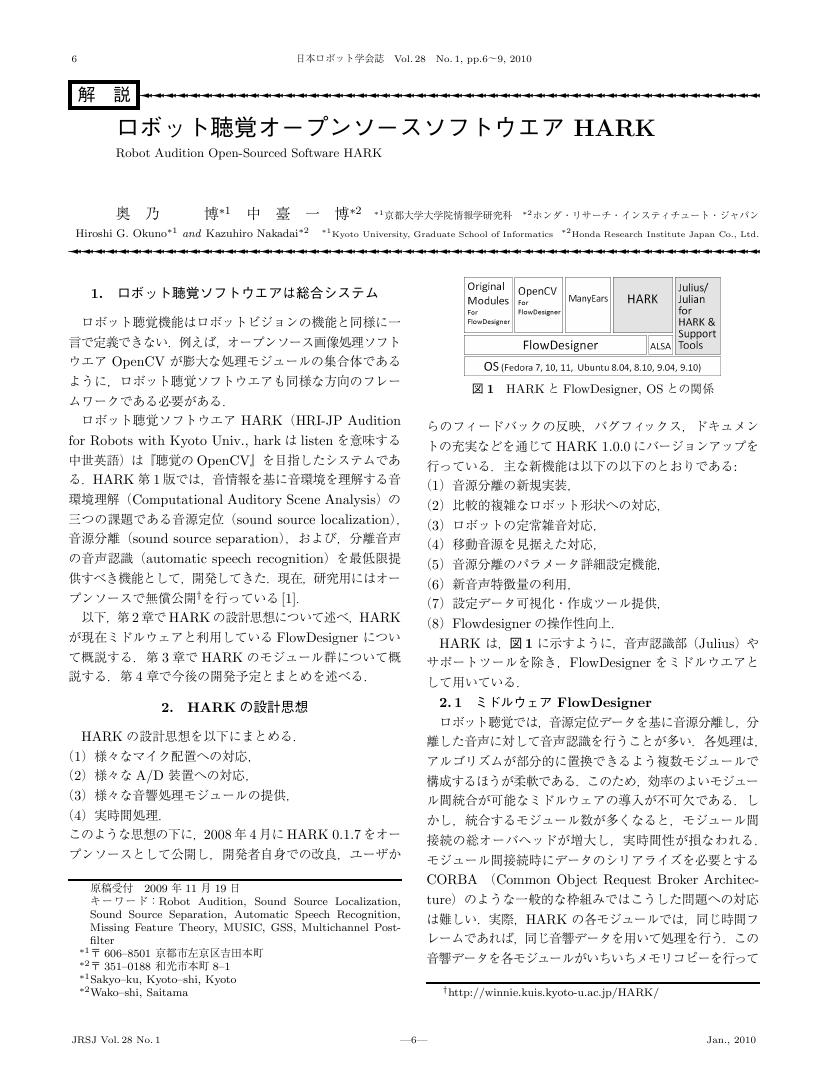

2 0 0 0 OA ロボット聴覚オープンソースソフトウエアHARK

- 著者

- 奥乃 博 中臺 一博

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.28, no.1, pp.6-9, 2010 (Released:2012-01-25)

- 参考文献数

- 4

- 被引用文献数

- 4 2

1 0 0 0 OA エコロケーションに基づく視覚シーンの再構成手法の提案と入力特徴量の検討

- 著者

- 岸波 華彦 糸山 克寿 西田 健次 中臺 一博

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.40, no.4, pp.351-354, 2022 (Released:2022-05-20)

- 参考文献数

- 12

This paper addresses reconstruction of visual scenes based on echolocation, aiming to develop auditory scene understanding for robots and systems. Although scene understanding technology with a camera and a LIDAR has been studied well, it is prone to changes in lighting conditions and has difficulty in detecting invisible materials. Ultrasonic sensors are widely used, but their use is limited to distance estimation. There is an unavoidable risk of ultrasonic exposure since most ultrasonic power exists in inaudible frequency ranges. To solve these problems, we propose a framework for echolocation-based scene reconstruction (ELSR). ELSR can reconstruct a visual scene using the transmitted/received audible sound, and it exploits a Generative Adversarial Network (GAN) to learn translation from input sound to a visual scene. As GAN is originally designed for image input, we carefully considered the difference between image and sound input and propose introducing cross-correlation and trigonometric function-based features to input audio features. The proposed framework is implemented based on pix2pix, a kind of conditional GAN, and a dataset for ELSR consisting of 10,800 pairs of input sound and depth images recorded at 28 indoor locations was newly created. Experimental results using the dataset showed the effectiveness of the proposed framework ELSR and audio features.

- 著者

- 中臺 一博 日台 健一 溝口 博 奥乃 博 北野 宏明

- 出版者

- 一般社団法人 日本ロボット学会

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.21, no.5, pp.517-525, 2003-07-15

- 参考文献数

- 11

- 被引用文献数

- 6 3

This paper describes a real-time human tracking system by audio-visual integrtation for the humanoid <I>SIG</I>. An essential idea for real-time and robust tracking is hierarchical integration of multi-modal information. The system creates three kinds of streams - auditory, visual and associated streams. An auditory stream with sound source direction is formed as temporal series of events from audition module which localizes multiple sound sources and cancels motor noise from a pair of microphones. A visual stream with a face ID and its 3D-position is formed as temporal series of events from vision module by combining face detection, face identification and face localization by stereo vision. Auditory and visual streams are associated into an associated stream, a higher level representation according to their proximity. Because the associated stream disambiguates parcially missing information in auditory or visual streams, “focus-of-attention” control of <I>SIG</I> works well enough to robust human tracking. These processes are executed in real-time with the delay of 200 msec using off-the-shelf PCs distributed via TCP/IP. As a result, robust human tracking is attained even when the person is visually occluded and simultaneous speeches occur.

- 著者

- 山田 泰基 Daniel Gabriel 糸山 克寿 西田 健次 中臺 一博

- 雑誌

- 第81回全国大会講演論文集

- 巻号頁・発行日

- vol.2019, no.1, pp.115-116, 2019-02-28

本研究では, 複数の移動機体に搭載された複数マイクロホンアレイによる移動音源の 3 次元軌跡推定手法について検討する. 単独のマイクロホンアレイでは音源方向のみ推定可能で,音源位置の推定は困難である.複数マイクロホンアレイを用いることで三角測量に基づく音源位置の推定が可能になり,さらに複数の移動機体を用いることでロバストな移動音源軌跡が可能になると期待される.各マイクロホンアレイから得られた音源方向より音源位置の候補点を算出し,各候補点に重みをつけながらUnscented Kalman Filterを適用することで移動音源軌跡を推定する.数値シミュレーションによる検証では,提案手法の推定誤差は0.1[m]以下であることが確認された.

1 0 0 0 OA マイクロフォンアレイとロボット聴覚を用いた野鳥の歌行動観測と生態理解への試み

本研究は、マイクロフォンアレイとロボット聴覚を用いて鳥類の歌コミュニケーションを自動観測し、歌の種類と位置情報から鳥個体間で行われる歌を介した相互作用を明らかにすること、そしてその知見を野鳥の生態理解へ応用することを目的とした。当該システムの活用により、森林と草原という異なった自然環境下で、これまでの観測手法では容易に得られなかった位置情報付きの音声データの収集が実現した。さらに鳥類の音声データの収集やその解析効率、再現検証性が向上した。またこれらの音声データの解析により、観測対象種の個体間において、各個体が同時に鳴くことを避ける時間的重複回避行動が明らかになった。

1 0 0 0 混合音を聞き分けるセンシング技術

- 著者

- 奥乃 博 中臺 一博 水本 武志

- 出版者

- 一般社団法人電子情報通信学会

- 雑誌

- 電子情報通信学会誌 = The journal of the Institute of Electronics, Information and Communication Engineers (ISSN:09135693)

- 巻号頁・発行日

- vol.95, no.5, pp.401-404, 2012-05-01

- 参考文献数

- 7

- 被引用文献数

- 4

私たちが日常耳にする音は複数の音や背景雑音が混じった混合音である.実世界で音情報を活用するためには「聞き分ける」機能が不可欠である.聞き分けるセンサ技術は,インストルメンテーション(装置化)という観点から音を収録するデバイス(センサ)と収録音に対する処理ソフトウェアから構成される.本稿では,混合音のセンサ技術の動向を,ロボット聴覚とカエルの合唱の観測について解説を行う.混合音を聞き分けるという立場から,音源定位,音源分離,分離音認識に取り組むべきであると考え,音環境理解という研究を過去15年進めてきた.離れて聞くという技術は,ロボットでは不可欠の技術であり,ロボット聴覚に不可欠な機能を統合的に提供するソフトウェアHARKを開発し,公開している.HARKの設計思想から具体的な実装まで概観し,その応用として,音環境可視化技術と人ロボット共生学への応用について報告する.また,カエルの合唱機構を音を聞き分けて解析する応用では,フィールドで聞こえる様々な音のために,音響処理だけでは難しいので,近傍の音を拾ってLEDを光らせる「カエルホタル」を開発した.カエルホタルを多数並べて実際の田んぼで観測し,カエルの鳴き方の観測実験についても合わせて報告する.以上の報告を通して,混合音を聞き分ける技術が,今後重要な技術になることを提案する.

1 0 0 0 OA 音響信号処理の変遷と最先端

- 著者

- 中臺 一博

- 出版者

- 一般社団法人 日本音響学会

- 雑誌

- 日本音響学会誌 (ISSN:03694232)

- 巻号頁・発行日

- vol.74, no.7, pp.394-400, 2018-07-01 (Released:2019-01-01)

- 参考文献数

- 32

1 0 0 0 OA ロボット聴覚の実環境理解に向けた多面的展開

- 著者

- 奥乃 博 中臺 一博 公文 誠 糸山 克寿 吉井 和佳 佐々木 洋子 昆陽 雅司 合原 一究 鈴木 麗璽 加賀美 聡 田所 諭

- 出版者

- 早稲田大学

- 雑誌

- 基盤研究(S)

- 巻号頁・発行日

- 2012-05-31

本研究では,ロボット聴覚ソフトHARKの「聞き分ける技術」を基に,自然環境・災害現場でも通用するように,豊富な機能拡充・高性能化と応用に取り組んだ.HARKはWindows版提供により9万件弱のダウンロードがあった.多人数インタラクション,音楽共演ロボットの可能性を示し, iGSVD-MUSICの開発によるUAV用音源定位の頑健化,索状ロボット用に姿勢推定・音声強調の開発により,レスキューロボットへの音利用の可能性を示し,さらに,カエルの合唱の解明,野鳥の鳴交解析のためのHARKBirdの開発と実地検証により音響生態学への可能性を実証し,ロボット聴覚の多面的展開のための基礎技術が確立できた.

1 0 0 0 OA 遠隔ユーザの音環境理解を支援するユーザインタフェース

- 著者

- 植田 俊輔 今井 倫太 中村 圭佑 中臺 一博

- 出版者

- 人工知能学会

- 雑誌

- 人工知能学会全国大会論文集 (ISSN:13479881)

- 巻号頁・発行日

- vol.26, 2012

人間は雑音が多い環境下であってもある程度どこでどのような会話が行われているかを理解する事が出来るが,遠隔操作を行うロボットアバタでは遠隔操作者が遠隔地の音環境を理解する事は困難である.本稿では,雑音環境下でも操作者と遠隔地がインタラクションをスムーズに行うことを支援するユーザインタフェースUI-ALTを提案する.オフライン実験によりUI-ALTは遠隔操作者の雑音環境理解に有用であることが示された.

1 0 0 0 音楽情景分析の処理モデルOPTIMAにおける単音の認識

- 著者

- 柏野 邦夫 中臺 一博 木下 智義 田中 英彦

- 出版者

- 一般社団法人電子情報通信学会

- 雑誌

- 電子情報通信学会論文誌. D-II, 情報・システム, II-情報処理 (ISSN:09151923)

- 巻号頁・発行日

- vol.79, no.11, pp.1751-1761, 1996-11-25

- 被引用文献数

- 70

音楽演奏の音響信号を対象として演奏情報を認識する試みとしては,従来自動採譜の研究が行われているが,複数種類の楽器音を含む音楽演奏を対象とする場合には,認識処理の有効性は極めて限られていた.そこで本論文では,複数種類の楽器音を含む音楽演奏の認識を音楽情景分析の問題としてとらえ,その解決を図る.ここで音楽情景分析とは,音楽演奏の音響信号から,単音や和音などの音楽演奏情報を記号表現として抽出することを指す.本論文ではまず,音楽情景分析を実現する上では情報統合の技術が不可欠であるとの認識から,ベイジアンネットワークによる情報統合の機構を備えた音楽情景分析の処理モデルOPTIMAを提案する.次に,特に単音の認識に的を絞って,提案する情報統合機構の有効性を示す.

1 0 0 0 ロボットを対象とした二階層視聴覚統合音声認識システム

- 著者

- 吉田 尚水 中臺 一博 奥乃 博

- 出版者

- The Robotics Society of Japan

- 雑誌

- 日本ロボット学会誌 (ISSN:02891824)

- 巻号頁・発行日

- vol.28, no.8, pp.970-977, 2010

Noise-robust Automatic Speech Recognition (ASR) is essential for robots which are expected to communicate with human in a daily environment. In such an environment, Voice Activity Detection (VAD) performance becomes poor, and ASR performance deteriorates due to noises and VAD failures. To cope with these problems, it is said that humans improve speech recognition performance by using visual information like lip reading. Thus, we propose two-layered audio-visual integration framework for VAD and ASR. The two-layered AV integration framework includes three crucial methods. The first is Audio-Visual Voice Activity Detection (AV-VAD) based on Bayesian network. The second is a new lip-related visual feature which is robust for visual noises. The last one is microphone array processing to improve Signal-to-Noise Ratio (SNR) of input signal. We implemented prototype audio-visual speech recognition system based on our proposed framework using HARK which is our robot audition system. Through voice activity detection and speech recognition experiments, we showed the effectiveness of Audio-Visual integration, microphone array processing, and their combination for VAD and ASR. Preliminary results show that our system improves 20 and 9.7 points of ASR results with/without microphone array processing, respectively, and also improves robustness against several auditory/visual noise conditions.

1 0 0 0 ロボットを対象とした二階層視聴覚統合音声認識システム

- 著者

- 中臺 一博 奥乃 博

- 出版者

- 一般社団法人電子情報通信学会

- 雑誌

- 電子情報通信学会技術研究報告. SP, 音声 (ISSN:09135685)

- 巻号頁・発行日

- vol.110, no.401, pp.7-12, 2011-01-20

- 参考文献数

- 18

我々が取り組んでいるロボット聴覚研究について,その位置づけや意義を解説し,これを実現するための高雑音下ハンズフリー音声認識へも適用可能な技術としてマイクロホンアレイを用いた動的環境下の実時間音源分離とその音声認識への適用について紹介する.紹介する技術は,ロボット聴覚ソフトウェアHARKとしてオープンソースで公開を行っている.そこで,これらの技術の有効性を,実際のロボットへのHARKの適用事例を通じて示す.

1 0 0 0 ロボット聴覚用オープンソースソフトウェア HARKの展開

- 著者

- 中臺一博 奥乃博

- 雑誌

- デジタルプラクティス

- 巻号頁・発行日

- vol.2, no.2, pp.133-140, 2011-04-15

ロボット聴覚用のオープンソースソフトウェアとして研究開発を行っているHARK (HRI-JP Audition for Robots with Kyoto Univ.) の展開について説明する.HARK は複数のマイクロフォン(マイクロフォンアレイ)からの入力をもとに,音源定位,音源分離,さらに分離音声の認識までをサポートするソフトウェアであり,GUIプログラミング環境上で様々なモジュールを配置・接続することにより,形状やマイクロフォンレイアウトが異なるロボットに対応させたり,用途に合わせたロボット聴覚システムを構築したりすることができる.本稿では,HARK の設計指針を解説し,HARKを用いて構築したシステムの応用例,HARKの展開も併せて報告する.

- 著者

- 奥乃 博 中臺 一博 大塚琢馬

- 出版者

- 一般社団法人情報処理学会

- 雑誌

- 情報処理 (ISSN:04478053)

- 巻号頁・発行日

- vol.50, no.8, pp.729-734, 2009-08-15

音楽のリズムに合わせて振舞う音楽ロボットを目標に据えると, 音楽情報処理の課題が見えてくる.

- 著者

- 山本 俊一 中臺 一博 辻野 広司 奥乃 博

- 出版者

- The Robotics Society of Japan

- 雑誌

- 日本ロボット学会誌 = Journal of Robotics Society of Japan (ISSN:02891824)

- 巻号頁・発行日

- vol.23, no.6, pp.743-751, 2005-09-15

- 被引用文献数

- 12

Robot audition is a critical technology in creating an intelligent robot operating in daily environments. To realize such a robot audition system, we have designed a missing feature theory based interface between sound source separation and automatic speech recognition (ASR) . In this interface, features distorted by speech separation are detected from input speech as missing features. The detected missing features are masked on recognition to avoid severe deterioration of recognition performance. By using the interface, we developed the robot audition system which recognizes multiple simultaneous speech. We also assess its general applicability by implementing it on three different humanoids, i.e., Honda ASIMO, SIG2, and Replie of Kyoto University. By using three simultaneous speeches as benchmarks, its general applicability was confirmed. When triphone is used and a size of vocabulary is 200 words, the average word correct of three simultaneous speech are 79.7%, 78.7%, and 82.7% for ASIMO, SIG2, and Replie, respectively.

1 0 0 0 OA 音環境理解に基づくロボット聴覚の構築

1 0 0 0 多数の人の声を一度に聞き分ける聴覚技術

- 著者

- 奥乃 博 中臺 一博

- 出版者

- 一般社団法人 電気学会

- 雑誌

- 電気学会誌 (ISSN:13405551)

- 巻号頁・発行日

- vol.131, no.3, pp.159-163, 2011-03-01 (Released:2011-03-01)

- 参考文献数

- 11

- 被引用文献数

- 1

本記事に「抄録」はありません。